Hören und sprechen zu können ist für die meisten Menschen eine Selbstverständlichkeit und fester Bestandteil des täglichen Lebens. Doch für weltweit 70 Millionen Menschen1 sieht die Realität anders aus: Sie sind gehörlos. Die Nutzung von Gebärdensprache ermöglicht es ihnen, soziale Beziehungen zu pflegen und sich aktiv am gesellschaftlichen Diskurs zu beteiligen. Oft stehen Gehörlose im Alltag dennoch vor Herausforderungen: Nur wenige Menschen haben den Umgang mit Gebärdensprache überhaupt erlernt. Zudem leben 80% der gehörlosen Menschen in Entwicklungsländern, in denen der Zugang zu Bildung und technologischen Hilfsmitteln meist stark eingeschränkt ist.

Doch was wäre, wenn Gebärdensprache genau so leicht zu verstehen ist wie gesprochene Sprache? Der Einsatz von Technologie und Künstlicher Intelligenz (KI) kann das möglich machen. Wir zeigen, wie KI die Gebärdenspracherkennung (Continuous Sign Language Recognition, kurz CSLR) auf mobilen Geräten mit und ohne Internetverbindung verbessern kann und eine App entwickelt, um Menschen mit Hörbeeinträchtigung eine gleichberechtigte Teilnahme am Leben zu ermöglichen.

1. Forschungsrelevanz: Barrierefreie Kommunikation bislang eingeschränkt

2. In drei Schritten zur mobilen Lösung

2.2 Modelle auswählen und integrieren

2.3 Entwicklung einer performanten App

1. Barrierefreie Kommunikation bislang eingeschränkt

Die Relevanz einer Lösung für eine barrierefreie Kommunikation ist groß: Im Alltag fehlt es meist an Dolmetschern oder technischen Hilfsmitteln, die eine reibungslose Kommunikation mit und für Gehörlose ermöglichen. In vielen öffentlichen Einrichtungen und Dienstleistungen sind die Anforderungen an barrierefreie Kommunikation noch nicht ausreichend umgesetzt. Auch im Bildungsbereich sind die Herausforderungen groß. Der Zugang zu qualitativ hochwertiger Bildung ist oft eingeschränkt, da nicht genügend Lehrmaterialien in Gebärdensprache verfügbar sind. Zudem sind viele Lehrer und Dozenten nicht ausreichend geschult, um effektiv mit gehörlosen oder schwerhörigen Schülern und Studierenden zu arbeiten.

2. In drei Schritten zur mobilen Lösung

Eine Lösung für Hörbeeinträchtigte ist nur sinnvoll, wenn sie ortsunabhängig im Alltag angewandt werden kann. Ziel war es deshalb, eine Anwendung für das Smartphone zu entwickeln. Forschungsleitend war dabei die Fragestellung, wie maschinelle Lernmodelle bei der Gebärdenspracherkennung auf mobilen Geräten effektiv eingesetzt und optimiert werden können.

Dieser Fragestellung näherten wir uns in mehreren Schritten:

- Datensätze analysieren: Zunächst musste die bestehende Datenbasis analysiert und definiert werden.

- Modelle auswählen und integrieren: Nun wurden passende KI-Modelle evaluiert und konvertiert, um sie nahtlos in iOS-Anwendungen zu integrieren

- Entwicklung einer performanten App: Voraussetzung war es, die Anwendung unabhängig von der Internetverbindung zu nutzen. Durch verschiedene Optimierungstechniken konnte zudem die Effizienz und Geschwindigkeit der Modelle auf mobilen Geräten erheblich verbessert werden.

2.1 Datensätze analysieren

Der Projektfokus lag vor allem auf der Integration bestehender, vortrainierter KI-Modelle für die Erstellung einer mobilen App. Aus diesem Grund haben wir uns auf die Datensätze fokussiert, die für das Training der Modelle verwendet wurden. Im ersten Schritt wurden öffentlich verfügbare Datensätze analysiert und konsolidiert. Für das Training der verwendeten KI-Modelle und die Evaluation der Modelle wurden umfangreiche Gebärdensprachdatensätze wie RWTH-PHOENIX_Weather 2014 T 2 verwendet. Die Daten sind aktuell noch auf spezielle Szenarien wie Wetter und bestimmte Perspektiven eingeschränkt. Um künftig eine umfassende Lösung zu bieten, wäre es notwendig, umfangreichere Datensätze zu erstellen, die vielfältige Szenarien, verschiedene Perspektiven und Abstände abdecken, um die Fähigkeiten der Modelle zu erweitern. Ein Beispiel: Um Modelle bestmöglich zu trainieren, braucht es u.a. Nah- und Fernaufnahmen, unterschiedliche Winkel und verschiedene Sprecher. Diese Variabilität weisen die Beispieldaten derzeit noch nicht auf. Dennoch haben die gewählten Daten und Modelle gezeigt, dass maschinelle Lernmodelle für die Gebärdenspracherkennung effektiv eingesetzt werden können.

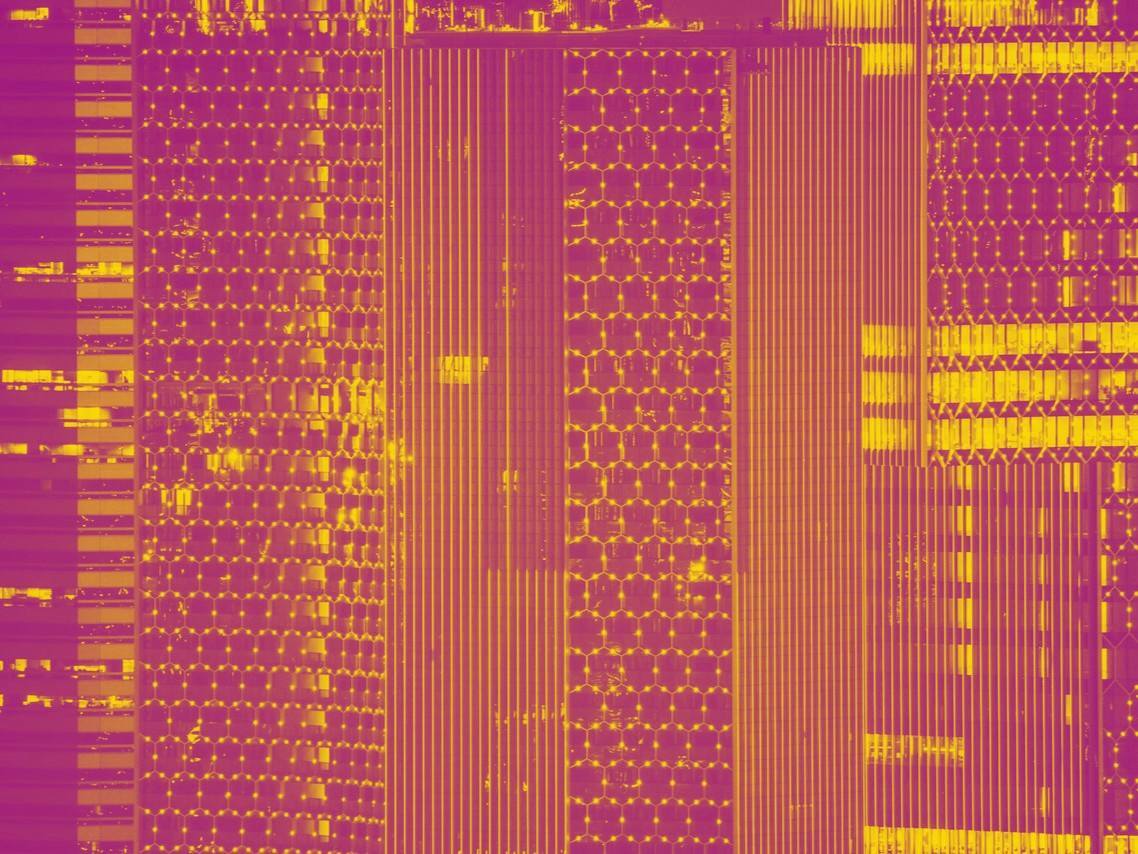

Die Abbildung zeigt Beispiele aus dem RWTH-PHOENIX-Weather 2014 Datensatz mit Heatmaps. Sie heben die wichtigsten Bereiche hervor, die vom Modell von Hu et al.3 gelernt wurden.

Abbildung 1: Visualisierung der Correlation-Maps, die in CorrNet verwendet werden

2.2 Modelle auswählen und integrieren

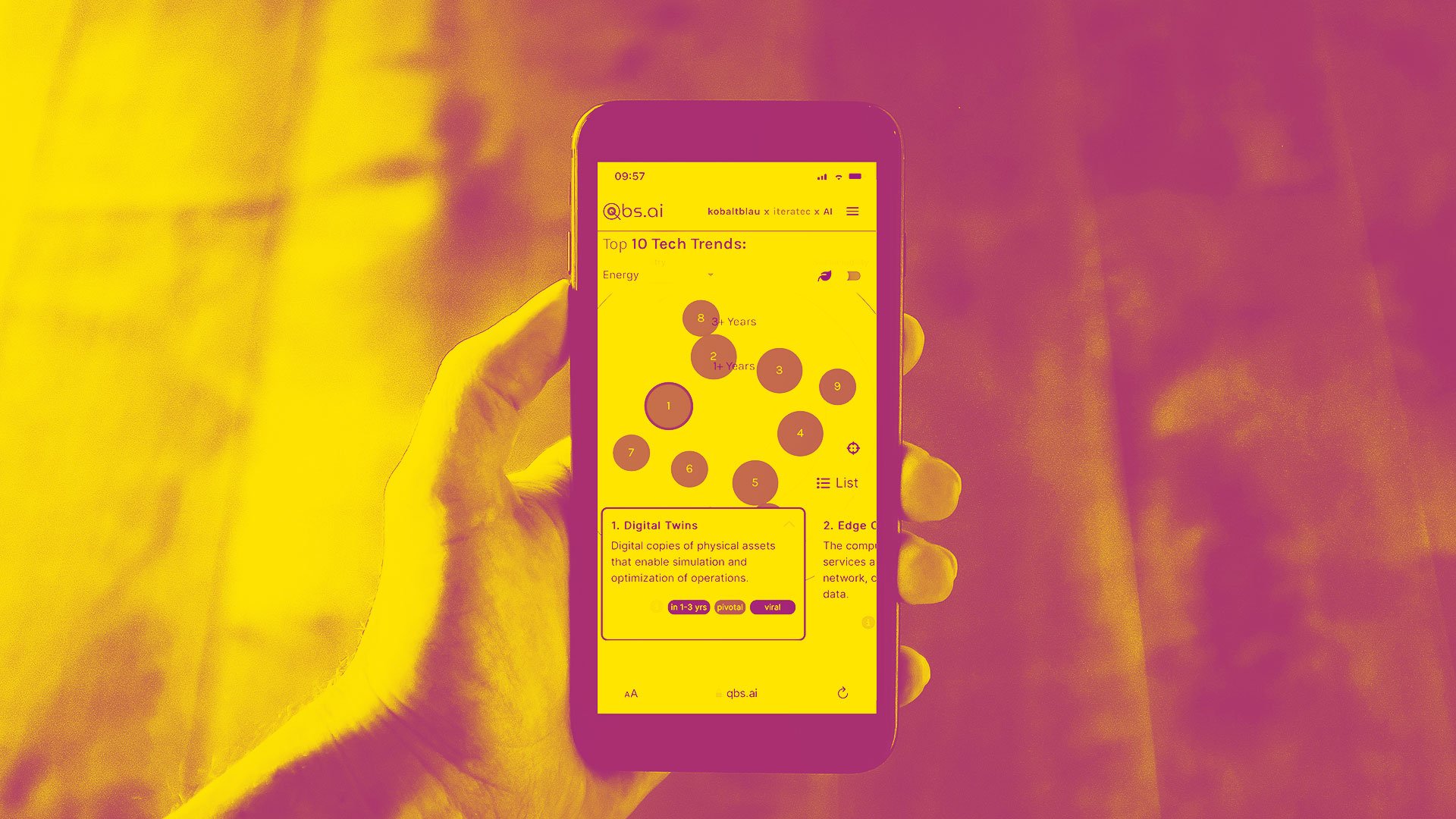

Im nächsten Schritt wurden vielversprechende KI-Modelle identifiziert. Diese wurden in das ONNX-Format konvertiert, um sie nahtlos in iOS-Anwendungen zu integrieren. ONNX ist ein spezielles Format, um Deep Learning Modelle zu repräsentieren und standardisieren. Dies ermöglicht übergreifend Portierbarkeit, z.B. von Server zu App (in diesem Fall von Python zu iOS).

Die verwendeten Modelle, darunter CorrNet, sind darauf spezialisiert, Videos in Form von sequenziellen Bildern zu verarbeiten und auf Basis moderner Computer-Vision- und Zeitreihen-Techniken die Übersetzung in natürliche Sprache vorherzusagen. CorrNet liest die Videodaten ein und nutzt komplexe Algorithmen, um die Bewegungen und Gesten in Gebärdensprache zu interpretieren und in Text umzuwandeln.

Abbildung 2: Architektur von CorrNet, die die Integration mehrerer CNN-Schichten und das Korrelationsmodul zeigt, das für die Verarbeitung der kontinuierlichen Gebärdensprache entscheidend ist.

2.3 Entwicklung einer performanten App

Während der Entwicklung der Anwendung wurden diverse technische als auch praktische Herausforderungen adressiert. Bei der Integration der Modelle auf das iOS-Zielsystem traten u.a. hardware-spezifische Hürden auf. Die größte Schwierigkeit bestand darin, dass sich die Bildverarbeitungsschritte in iOS als deutlich komplexer gestalteten als in Python, dem Industriestandard für maschinelles Lernen.

Die darauffolgende Optimierung der Bildverarbeitung bringt eine eigene Ebene der Komplexität mit sich. Es galt, die beste Methode zur Reduzierung der Verarbeitungszeit zu finden, ohne die Genauigkeit zu beeinträchtigen - ein Prozess, der viel Geduld und Experimentierfreude erforderte.

Ein weiteres Problem waren Speicherengpässe bei großen Bildsequenzen, besonders bei höheren Bildfrequenzen. Dies erforderte sorgfältige Anpassungen und zahlreiche Tests, um die optimale Balance zwischen Bildqualität und Speichernutzung zu erreichen.

Eine schnelle, internetunabhängige Lösung

Die Ergebnisse zeigen, dass die optimierten Modelle auf mobilen Geräten eine Genauigkeit erreichen, die mit den serverbasierten Varianten vergleichbar ist. Die lokale Verarbeitung der App bietet deutliche Geschwindigkeitsverbesserungen und ist unabhängig von der Internetverbindung, was die Nutzbarkeit erheblich steigert. Im Vergleich zur serverbasierten Lösung ist die lokale Verarbeitung schneller und bietet insgesamt eine robustere Leistung. Diese Fortschritte tragen dazu bei, Kommunikationsbarrieren abzubauen und die Lebensqualität von gehörlosen Menschen zu verbessern.

Ausblick

Das Projekt zeigt, dass der Einsatz von Künstlicher Intelligenz für diesen Zweck die soziale Inklusion und Autonomie gehörloser Menschen erheblich verbessern könnte. Die Vorstellung, das Smartphone zu zücken und eine Unterhaltung in Gebärdensprache zu verstehen, wäre ein großer Schritt in Richtung einer inklusiveren Gesellschaft.

Die beschriebene Forschung, die im Rahmen einer Studienarbeit an der Hochschule Landshut durchgeführt und von iteratec begleitet wurde, ist nur ein Anfang. Um die Gebärdenspracherkennung weiter zu verbessern, müssen die Datensätze erweitert und diversifiziert werden, indem Daten aus verschiedenen Perspektiven und Kontexten gesammelt werden. Zudem besteht der Bedarf, die Modelle weiter zu optimieren, um ihre Effizienz und Genauigkeit zu steigern. Der eingeschlagene Weg, diese Technologie für alle zugänglich zu machen und Kommunikationsbarrieren abzubauen, ist vielversprechend und bietet große Potenziale für die Weiterentwicklung.

Haben Sie Fragen oder benötigen Sie Unterstützung?

Mehr zu den Möglichkeiten von Künstlicher Intelligenz für Ihr Unternehmen finden Sie auf unserer Webseite.

Quellen:

[1] World Federation of the Deaf, https://wfdeaf.org/ [06.09.24]

[2] Camgöz, N. C., Hadfield, S., Koller, O., Ney, H., & Bowden, R. (2018). Neural Sign Language Translation. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), Salt Lake City, UT. https://doi.org/10.1109/CVPR.2018.00901

[3] Hu, L., Gao, L., Liu, Z., & Feng, W. (2023). Continuous Sign Language Recognition with Correlation Network. arXiv. https://arxiv.org/abs/2303.03202

Blog abonnieren

Weitere Artikel

- Februar 2026

- Januar 2026

- Dezember 2025

- November 2025

- Oktober 2025

- August 2025

- Juli 2025

- Juni 2025

- Mai 2025

- April 2025

- März 2025

- Februar 2025

- Januar 2025

- Oktober 2024

- September 2024

- August 2024

- Juli 2024

- Juni 2024

- Mai 2024

- April 2024

- März 2024

- Februar 2024

- Januar 2024

- Dezember 2023

- November 2023

- September 2023

- August 2023

- Juli 2023

- Juni 2023

- Mai 2023

- April 2023

- Februar 2023

- Dezember 2022

- November 2022

- Mai 2022

- April 2022

- März 2022

- Januar 2022

- Dezember 2021

- November 2021

- Oktober 2021

- August 2021

- Juli 2021

- Juni 2021

- Mai 2021

- April 2021

- Dezember 2020

- Oktober 2020

- September 2020

iteratec

iteratec ist der Partner für alle, die zu den Gewinner:innen der digitalen Transformation gehören wollen. Mit individuellen, überlegenen Lösungen eröffnen wir unseren Kunden technologische wie unternehmerische Potenziale. Denn: Wenn Scheitern keine Option ist, sind wir der Partner, der den Unterschied macht. So haben wir seit 1996 mehr als 1.000 Projekte zum Erfolg geführt und eine Kundenzufriedenheit von 97%.